Michael Levin e Tal Shomrat da Universidade de Tuft, "ensinaram" planarias a procurar a luz.

Os vermes eram recompensados com comida e punidos quando ficavam no escuro. Depois do treino estar completo, cortaram-lhes a cabeça, que por sorte, cresce de volta.

O cérebro destes vermes foi assim destruído e substituido por outro, que cresce naturalmente de volta. Isso é algo que dá sempre jeito, mas o que é marcante neste estudo é que estes vermes mantiveram a memória de como lidar com a luz.

Eu penso que a melhor explicação para este fenómeno é encontrada nos trabalhos do Prof. António Damásio. Segundo este neurologista, as emoções são respostas orgânicas. Os sentimentos são como que sensações dessas emoções.

Neste quadro teórico, o que pode acontecer com os vermes é que a resposta orgânica é a mesma para o mesmo sinal vindo do cérebro. Ou seja, o cérebro processa o ambiente e envia a informação simplificada mas inequívoca para o corpo. O corpo produz uma resposta, que é regulada por feed-back com o cérebro, acabando por associar boas e más emoções a acontecimentos e fenómenos. O corpo não tem necessariamente a memória do que deve fazer. Nem faz a mínima ideia de algo como luz ou escuro. Apenas de como reage caso o cérebro envie determinada informação, provavelmente consistindo num conjunto de sinais variados para vários órgãos.

O cérebro depois dá ordens motoras de acordo com as emoções que recebe do corpo.

Deste modo, o que encontramos aqui, é a demonstração de que as emoções são reguladores comportamentais sendo mesmo capazes de mimetizar a memória, e são mesmo quadros organicos. Memórias que por tudo o que sabemos, apenas são possíveis com aparato neurológico mais complexo que só existe no cérebro. E por isso, ao substituir o cérebro, se o novo sistema nervoso central for igualmente capaz de processar a informação ambiental de modo a enviar a mesma sinalização ao corpo, a resposta do corpo é a mesma porque o corpo é o mesmo. E o cérebro será capaz de enviar a mesma informação ao corpo porque esta informação será produzida de modo lógico.

Se isto estiver correcto, esta interpretação, este trabalho não prevê que a memória dos humanos possa estar no corpo. Ou que haja uma alma onde o verdadeiro espectáculo do Eu funciona. Factos, números, imagens, terão de ser guardados no cérebro. Por isso, pessoas com o cérebro desligado do corpo mantém memória normal. Estamos a falar de coisas diferentes.

Estamos a falar de emoções e de uma demonstração da sua utilidade em seres muito simples e de um modo muito simples. A memória tal como a temos será uns quantos furos acima na sua capacidade de gerar "facts and figures" ou imagens. Será no entanto ainda capaz de gerar respostas emocionais associadas, como todos sabemos.

Cepticismo, naturalismo e divulgação científica. Uma discussão sobre o que é ou não matéria de facto.

Páginas

- Página inicial

- Teoria da Relatividade

- Mecânica Quântica

- Criacionismo

- Ciência

- Teoria da Evolução

- Medicinas Alternativas

- Astrologia

- Aquecimento Global Antropogénico

- Importância do Consenso Científico

- Teorema de Godel

- Evidência Anedótica

- Propriedades emergentes e a mente.

- Leitura a frio vs mediunismo/etc.

- O que é o cepticismo?

quinta-feira, 25 de julho de 2013

segunda-feira, 22 de julho de 2013

Estatística bayesiana, pequena introdução

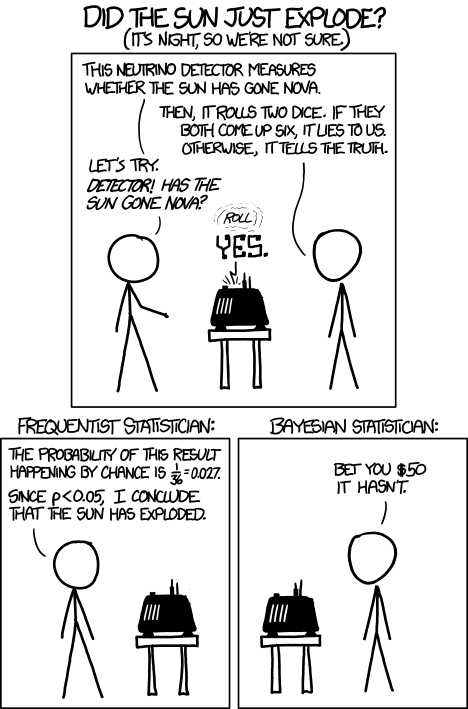

"Cartoon" retirado do XKCD

Uma ferramenta de indução

É vulgar considerar que testes que resultam em determinados valores de P podem atribuir probabilidades a hipóteses. Por exemplo, o erro de considerar que "P menor que 0,05 quer dizer que temos 95% de probabilidade de ter a nossa hipótese correcta", é muito comum. Mas a estatística frequentista, com os seus valores de P, não pode atribuir probabilidades a hipóteses. De todo.

O que o valor de P representa, é o numero de vezes que teríamos um determinado resultado, num grande numero de repetições, considerando que a hipótese nula é a verdadeira. Não diz nada acerca da probabilidade da hipotese "nao-nula" ou sequer da nula, que na realidade estamos a presumir que é verdadeira - apenas permite rejeitá-la ou aceitá-la (um resultado binário) dentro de determinados parâmetros. Por estas razões, na prática, dá-nos um valor que diz muito pouco acerca de casos particulares. Por esta razão também, leva a que se admitam muitos falsos positivos. Isso acontece ao induzir muitos a aceitar cada teste que rejeita a hipótese nula como suficiente para considerar a probabilidade de uma hipótese como elevada, quando esta é realmente calculada de outra forma, e quando esta é realmente improvável. É tanto mais grave quanto mais improvável for essa hipótese.

O que o valor de P representa, é o numero de vezes que teríamos um determinado resultado, num grande numero de repetições, considerando que a hipótese nula é a verdadeira. Não diz nada acerca da probabilidade da hipotese "nao-nula" ou sequer da nula, que na realidade estamos a presumir que é verdadeira - apenas permite rejeitá-la ou aceitá-la (um resultado binário) dentro de determinados parâmetros. Por estas razões, na prática, dá-nos um valor que diz muito pouco acerca de casos particulares. Por esta razão também, leva a que se admitam muitos falsos positivos. Isso acontece ao induzir muitos a aceitar cada teste que rejeita a hipótese nula como suficiente para considerar a probabilidade de uma hipótese como elevada, quando esta é realmente calculada de outra forma, e quando esta é realmente improvável. É tanto mais grave quanto mais improvável for essa hipótese.

A estatística que consegue extrair conclusões dos dados de forma a dar probabilidades a hipóteses particulares é a bayesiana. Esta estatística usa uma probabilidade "à priori" para chegar a uma probabilidade "à posteriori", para um determinado caso, resultando assim numa ferramenta indutiva. Não é, no entanto, muito fácil de conseguir a tal probabilidade "à priori", já que na prática requer grandes quantidades de dados, nem é muito intuitiva inicialmente ou rápida de calcular.

Um exemplo

Stephen Pinker conta no seu livro "How the mind works" que se colocou a 60 alunos da escola de medicina de Harvard a seguinte questão:

"Se um teste para detectar uma doença cuja prevalência é de 1/1000 tem uma taxa de falsos positivos de 5% qual a probabilidade de uma pessoa a quem o teste deu positivo de ter a doença, sendo que não sabemos nada do seu quadro clínico."

Nota: Falso positivo = percentagem de pessoas saudáveis que têm resultado positivo.

Prevalência = proporção de pessoas com a doença numa população.

A resposta mais popular foi 95%. A resposta certa é 2%. Isto em Harvard.

Neste caso precisamos de atribuir uma probabilidade a uma hipótese, por isso precisamos de uma ferramenta que diga algo acerca de uma caso particular extraindo conhecimento de números gerais. Precisamos de estatística bayesiana e aparecerem dados de probabilidade "à priori" na questão, como a prevalência da doença, deveria ter levantado bandeiras vermelhas aos alunos que responderam. Pensando apenas um pouco no assunto, torna-se intuitivo o facto de que se aceitamos que a probabilidade do teste (de 5% para falsos positivos) atribuir 95% de certeza de ser positivo, é porque estamos a postular uma prevalência assustadoramente próxima de 100%. Mas essa é nos dito que é de 0,1%. Outro problema também é considerar a taxa de falsos positivos como a proporção dos resultados positivos (no conjunto dos positivos) que vêm de pessoas saudáveis em vez de interpretar isso como a proporção de resultados positivos no grupo de pessoas saudáveis.

Então o valor tem de ser calculado assim:

Multiplica-se a prevalência pela sensibilidade do teste (taxa de verdadeiros positivos, presumidamente 1 neste caso), dividindo depois pela incidência de testes positivos. A incidência de testes positivos, ou seja, todos os resultados positivos, quer de pessoas doentes ou não, calcula-se somando os doentes que têm resultado positivo, que são neste caso 1/1000 vezes 1 (presumido) com as saudáveis que têm resultado positivo ou seja 999/1000 x 0,5.

Uma maneira fácil de compreender isto é recorrendo a um quadro. Para facilitar vou repetir todo o quadro conforme preencho passo a passo.

Comecemos por admitir que temos uma população de 100000 pessoas para visualizar melhor alguns resultados:

Têm a doença

|

Não têm a doença

|

Total

|

|

Teste positivo

|

|||

Teste negativo

|

|||

Totais

|

100000

|

Têm a doença

|

Não têm a doença

|

Total

|

|

Teste positivo

|

|||

Teste negativo

|

|||

Totais

|

100

|

100000

|

Têm a doença

|

Não têm a doença

|

Total

|

|

Teste positivo

|

|||

Teste negativo

|

|||

Totais

|

100

|

99900 (100000 – 100)

|

100000

|

Têm a doença

|

Não têm a doença

|

Total

|

|

Teste positivo

|

4995

| ||

Teste negativo

|

(99900 – 4995) 94905

|

||

Totais

|

100

|

99900

|

100000

|

Têm a doença

|

Não têm a doença

|

Total

|

|

Teste positivo

|

100

|

4995

|

5095

|

Teste negativo

|

0

|

94905

|

94905

|

Totais

|

100

|

99900

|

100000

|

Se queremos saber a proporção de positivos verdadeiros entre os positivos todos, que é realmente a resposta à pergunta, então temos:

100/5095 = aproximadamente 0,02 ou 2%.

Conseguimos saber assim a probabilidade de B (ser verdadeiramente positivo, ter a doença) dado A (o teste deu positivo).

Isso escreve-se P(B/A)

Este exemplo, para além de expor como funciona esta estatística, demonstra bem como probabilidades à priori baixas levam a verdadeiras probabilidades baixas, mesmo com testes de qualidade a dar positivo. Os tais 2% contra o valor de 95% que é aferido intuitivamente.

Tem sido argumentado que muito sofrimento poderia ser evitado ao explicar isto convenientemente a pessoas que tiveram testes positivos para doenças raras e/ou feitos com pouca indicação clínica (sem sintomas, factores de risco, etc). Ou seja, quando a probabilidade de ter a doença é pequena, já que testes positivos vão sempre haver.

Notar que nestas condições, e com um teste com boas características, há mais falsos positivos que verdadeiros positivos em numero de pessoas.

Este exemplo, para além de expor como funciona esta estatística, demonstra bem como probabilidades à priori baixas levam a verdadeiras probabilidades baixas, mesmo com testes de qualidade a dar positivo. Os tais 2% contra o valor de 95% que é aferido intuitivamente.

Tem sido argumentado que muito sofrimento poderia ser evitado ao explicar isto convenientemente a pessoas que tiveram testes positivos para doenças raras e/ou feitos com pouca indicação clínica (sem sintomas, factores de risco, etc). Ou seja, quando a probabilidade de ter a doença é pequena, já que testes positivos vão sempre haver.

Notar que nestas condições, e com um teste com boas características, há mais falsos positivos que verdadeiros positivos em numero de pessoas.

Teoria

A formula que Bayes descobriu, (e demonstrou) é:

P(B/A) = P(B) x P(A/B)

[P(B)xP(A/B)]+[P(~B)xP(A/~B)] (a pedido posso dar a demonstração).

Sendo no exemplo apresentado:

P(A) probabilidade de A

~B = "não B"

Neste caso: B = ter a doença;

~B = não ter a doença

A = teste positivo.

Outro exemplo

Ao testar repetidamente qualquer coisa cuja hipótese é muito improvável, a estatística frequentista prevê que se vão rejeitar falsamente (face a um numero grande de testes) as hipóteses nulas num numero reduzido desses testes, só por acaso. Pior. Como existe uma tendência para publicar apenas resultados positivos, que rejeitam a hipótese nula, esses resultados vão aparecer ainda mais isolados do que aquilo a que a nossa tendência natural para nos focarmos em resultados positivos nos leva. Por isso temos estudos de homeopatia e outras coisas implausíveis com Ps "bons" - mas que não significam nada - muito popularizados pelos crentes. Não significam nada porque para saber a probabilidade de um teste ser um verdadeiro positivo temos de usar o resto das coisas que sabemos que condicionam essa probabilidade. Tal como no exemplo anterior. E tal como no exemplo anterior vamos ter imensos falsos positivos em Ps usuais quando a probabilidade que condiciona a interpretação do nosso teste é baixa. E no caso da homeopatia, por exemplo, ciência bastante básica leva-nos a uma probabilidade à priori muito baixa, o que torna testes singulares e valores de P usuais muito fracos. Afirmações extraordinárias requerem provas extraordinárias, e podemos agora compreender como esta frase é na realidade uma afirmação de matemática bayesiana. Por muito desagradável que esta matemática seja para alguns, a verdade é que para provar a homeopatia precisávamos que todos os ensaios clínicos (e em grande numero) tivessem resultados sempre positivos para valores de P muito mais baixos que 0,05 ou até 0,01. Porque precisávamos que essa evidência fosse tão forte que mostrava que todos os outros testes que formaram os alicerces da ciência estavam errados. No caso da homeopatia a contradição com a ciência começa ao nível da química e acaba ao nível da terapêutica médica. E no entanto, tal como esperado, lá aparecem falsos positivos.

Em conclusão

A estatística bayesiana dá-nos probabilidades para casos particulares, usando tudo o que já se sabe anteriormente. A estatististica frequentista não permite isso, de facto faz um pouco o contrário, ou seja, prevê resultados futuros para muitas repetições dado um teste que temos à frente (é dedutiva). Por isso conforme vamos tendo cada vez mais conhecimento acumulado e melhor capacidade de estabelecer as probabilidades relacionadas com as hipóteses em causa, menos desculpa temos para não usar estatística bayesiana para dar significado ao resultado dos estudos e testes que fazemos.

Etiquetas:

estatística bayesiana

sábado, 20 de julho de 2013

Não há aquecimento desde 1998. Dizem. Mas não é verdade.

Este é um argumento recorrente dos que não acreditam no aquecimento global. Normalmente, entre insultos à honestidade dos "Warmists" e imensos adjectivos depreciativos para cada afirmação cientifica com que não concordam, lá vem o grande argumento de que não há aquecimento entre tal e tal data. Mas é treta.

http://www.sciencedirect.com/science/article/pii/S0375960112010389

O meu FAQ aqui:

http://cronicadaciencia.blogspot.pt/2012/12/questoes-frequentes-sobre-o-aquecimento.html

quarta-feira, 3 de julho de 2013

Imparcialidade

Um exercício fantástico com um fim prático:

Imaginem que antes de nascermos, existíamos como espírito, com amplo conhecimento de causas e coisas, excepto acerca dos particulares pessoais após o nascimento.

Não saberíamos o sexo, a etnia, o local de nascimento, o estrato sócio-económico, a inteligência, a força física ou a saúde que teríamos neste mundo. Todas aquelas coisas que sejam inatas, ou perto disso, estariam incluídas neste véu de ignorância.

Teríamos no entanto, nessa altura antes de nascer, a oportunidade de participar na construção das leis que encontraríamos.

Como gostaríamos, nessas condições, que fossem as coisas?

Imaginem que antes de nascermos, existíamos como espírito, com amplo conhecimento de causas e coisas, excepto acerca dos particulares pessoais após o nascimento.

Não saberíamos o sexo, a etnia, o local de nascimento, o estrato sócio-económico, a inteligência, a força física ou a saúde que teríamos neste mundo. Todas aquelas coisas que sejam inatas, ou perto disso, estariam incluídas neste véu de ignorância.

Teríamos no entanto, nessa altura antes de nascer, a oportunidade de participar na construção das leis que encontraríamos.

Como gostaríamos, nessas condições, que fossem as coisas?

Subscrever:

Mensagens (Atom)